2024年的诺贝尔物理学奖授予了两位在机器学习领域做出开创性贡献的科学家:约翰·霍普菲尔德(John Hopfield)和杰弗里·辛顿(Geoffrey Hinton)。他们的工作不仅推动了人工智能的发展,还让我们对大脑的工作原理有了更深入的理解。

本文将带你一起探索这两位科学家如何将物理学的原理应用于构建现代机器学习的基础。

近年来,机器学习的快速发展使得计算机可以自动翻译语言、解读图像,甚至与人类进行有条理的对话。然而,这种技术不仅对日常生活产生了深远影响,也成为了科学研究中不可或缺的工具。

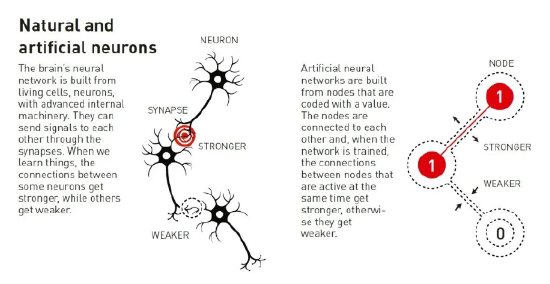

在机器学习中,计算机不再按照传统软件的“配方式”逻辑运作,而是通过例子“学习”,从而解决复杂的问题,例如识别图像中的物体。今天的人工智能主要依赖于这种技术,它背后的基本结构称为人工神经网络。

人工神经网络最早是为了模仿大脑的运作原理而设计的。早在1940年代,科学家们开始研究大脑中神经元和突触的数学模型,试图理解人类的学习和记忆机制。1960年代末,一些令人沮丧的理论结果导致许多研究人员怀疑这些神经网络永远不会有任何实际用途。

然而,1980年代,人工神经网络再度引起人们的兴趣,当时有多项有影响的重要想法诞生,其中就包括今年诺贝尔物理学奖获得者约翰·霍普菲尔德和杰弗里·辛顿的研究成果。

约翰·霍普菲尔德(John Hopfield)创建了一种可以存储和重建信息的结构。杰弗里·辛顿(Geoffrey Hinton)发明了一种可以独立发现数据属性的方法,这种方法对于目前使用的大型人工神经网络至关重要。

生物神经元与人工神经元

霍普菲尔德网络:利用物理学存储与重构记忆

你可能有这样的经历,当你试图回忆一个不常用的词汇时,你通常会在相似的词语中搜索,直到找到正确的那个。这种通过类似词语联想回忆的过程,正是霍普菲尔德在1982年提出的“联想记忆”网络。

霍普菲尔德网络可以看作是一个由节点和连接组成的复杂系统,每个节点可以存储一个值,类似于黑白照片中的像素。如果把霍普菲尔德网络当作是一个拼图游戏,每个拼图块则代表一个节点,而拼图块之间的凹槽和凸起则代表节点间的连接。

当你开始拼图时,你可能会从一个边缘块开始,逐渐找到与之匹配的块,直到整个画面逐渐清晰。在霍普菲尔德网络中,即使拼图块被部分打乱或缺失,网络也能通过调整块之间的连接(拼图块的顺序),最终恢复出完整的图像。

霍普菲尔德之前曾利用他的物理学背景探索分子生物学的理论问题。当他被邀请参加一次神经科学会议时,他接触到了对大脑结构的研究。他对所学内容非常着迷,并开始思考简单神经网络的动态。

当神经元共同作用时,它们会产生新的强大特性,而这些特性对于只关注神经元网络各个组成部分的人来说是无法察觉的。

2024年诺贝尔物理学奖发布会现场

1980年,霍普菲尔德离开了普林斯顿大学,接受了加州理工学院的化学和生物学教授职位。在那里,他可以免费使用计算机资源进行实验并发展他的神经网络思想。

尽管霍普菲尔德的研究兴趣让他超出了物理学相关的研究领域,但受益于自己的物理学背景,他从物理学中的自旋系统的特性获得灵感。

在自旋系统中,原子像微小的磁体,邻近原子的自旋相互影响,形成稳定的状态。霍普菲尔德使用了类似的原理,将节点和连接模拟为自旋系统,通过调节网络的能量来保存图像。即便是接收到模糊的输入,网络也能根据能量最小化原则重构出清晰的图像。这一技术也被广泛应用于数据去噪和丢失数据的重构。

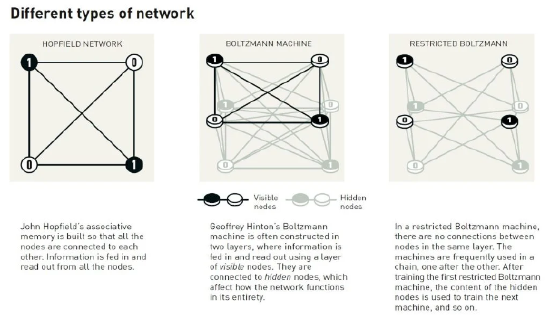

不同类型的人工神经网络

玻尔兹曼机:使用十九世纪的物理学进行分类

当霍普菲尔德发表他的联想记忆研究时,杰弗里·辛顿正在美国匹兹堡的卡内基梅隆大学工作。此前,他曾在英格兰和苏格兰学习过实验心理学和人工智能,他希望知道机器是否能学会以类似于人类的方式处理信息。

1985年,杰弗里·辛顿、计算神经生物学家特伦斯·谢诺夫斯基(Terrence Sejnowski) 等人扩展了霍普菲尔德的思想,创建了一类新的模型,称为玻尔兹曼机,以19世纪物理学家路德维希·玻尔兹曼(Ludwig Boltzmann ) 的名字命名。顾名思义,这些模型的设计植根于玻尔兹曼开创的统计物理学。

统计物理学是一门研究由许多相似元素组成的系统的科学,例如气体中的分子。由于追踪气体中所有分子个体的运动几乎不可能,因此我们可以把它们看成一个整体从而确定气体的总体性质,如压力或温度。

在统计物理学中,系统状态的概率分布通常与能量函数有关,这一思想在玻尔兹曼机的设计中得到了体现。玻尔兹曼机通过优化一个称为玻尔兹曼能量函数的目标函数,来学习数据的概率分布。

玻尔兹曼机一般由可见层和隐含层两部分组成,这两层之间以及隐含层内部都有权重相互连接。这种结构类似于统计物理学中的系统模型,其中可见层可以看作是系统的可观测部分,而隐含层则代表系统的隐藏或不可观测部分。权重连接则反映了变量之间的相互作用关系。

经过训练后的玻尔兹曼机,只需基于以前训练时的样本,就能识别并分类新输入的信息,而不需特定的指令。玻尔兹曼机还可生成新模式,使其成为早期生成模型的代表之一。

这项技术在今天深层神经网络的开发中起到重要作用,并被应用于推荐系统等实际场景中。

玻尔兹曼机到底是如何工作的呢?

我们可以看下面的例子。

如果把玻尔兹曼机看作是一个由许多彩色灯泡组成的复杂网络,这些灯泡分为两类:一类是“可见灯泡”(对应可见节点),它们位于网络的表层,能够直接与外界交互,就像是商场里展示商品的橱窗;另一类是“隐藏灯泡”(对应隐藏节点),它们隐藏在内部,不直接可见,但影响着整个网络的状态,就像是商场后台的库存管理系统。

现在,假设这个网络(玻尔兹曼机)被训练成了一个“时尚推荐系统”。在训练阶段,系统通过观察大量顾客的购买记录(这些记录就像是输入到可见节点的信息),同时内部隐藏节点不断调整自己的状态(即更新灯泡的亮灭),来逐渐学习时尚趋势和顾客偏好。这个过程就像是在不断调整商场橱窗里的商品布局和库存,使得整个系统(商场)的能量(可以理解为混乱度或不符合顾客需求的程度)逐渐降低,达到一个更加和谐、有序的状态。

训练完成后,当一个新的顾客走进商场(即向玻尔兹曼机输入新的信息),不需要店员(即不需要明确的指令),系统就能自动根据顾客的过往行为(通过可见节点)和内部学习到的时尚趋势(通过隐藏节点),智能地推荐商品(即分类新输入的信息)。这就像顾客一靠近橱窗,系统就自动调整灯光,突出显示那些最可能吸引顾客的商品。

更进一步,玻尔兹曼机不仅能推荐已知的商品组合,还能“创造”新的时尚搭配(生成新模式),就像是商场的设计师团队根据现有库存和流行趋势,设计出全新的搭配方案,引领新的潮流。

在这个例子中,玻尔兹曼机就像是一个既聪明又灵活的商场管理员,能够根据顾客的需求和市场的变化,不断优化商品展示和推荐策略,为顾客提供个性化的购物体验。

机器学习的应用已经扩展到科学前沿领域

机器学习的未来:挑战与机遇并存

从2010年左右开始,机器学习已经经历了爆炸式发展。与霍普菲尔德在1982年只能使用30个节点的网络相比,今天的深度神经网络已经包含了数万亿个参数。这些巨型网络能够处理庞大的数据量,使得计算机的识别和分类能力达到了前所未有的高度。

这种技术的广泛应用不仅限于日常生活中的语言和图像处理,还扩展到了科学研究的前沿领域,包括探索希格斯玻色子、检测引力波,以及研究材料的分子结构等。

约翰·霍普菲尔德和杰弗里·辛顿的工作为机器学习革命奠定了基础,也使得人工神经网络技术成为人工智能发展的核心。然而,这项技术的快速发展也引发了诸多伦理问题,特别是数据隐私和算法偏见。

随着计算能力和数据量的持续增长,未来的机器学习应用将继续拓展我们的科技边界,而物理学与机器学习的交融将不断带来新的可能性。